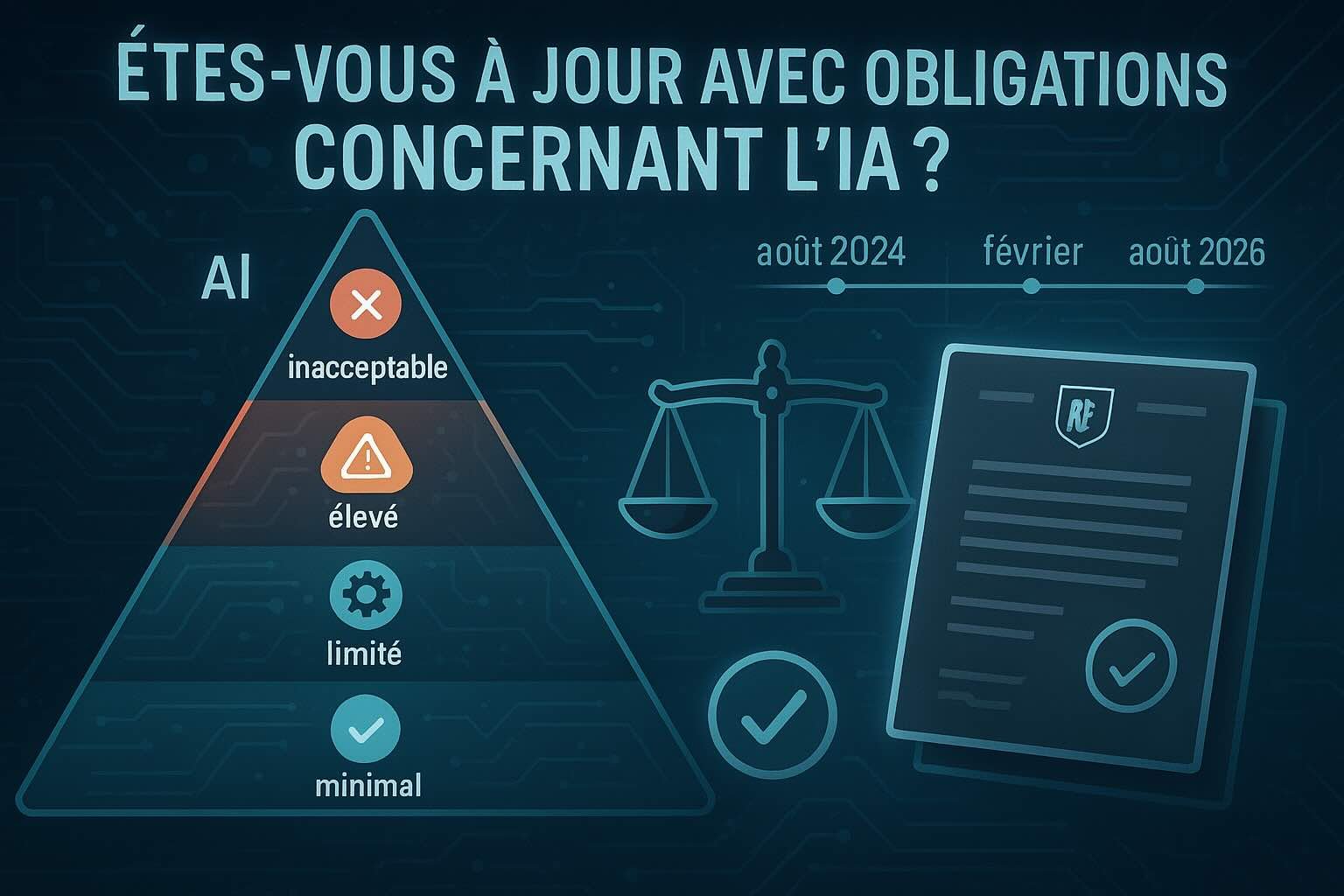

Êtes-vous à jour avec vos obligations concernant l’IA ? Décryptage des règles françaises et européennes en avril 2025: Depuis l’entrée en vigueur du Règlement européen sur l’IA (IA Act) en août 2024, les obligations se multiplient pour les organisations. En avril 2025, où en êtes-vous ? Tour d’horizon des règles passées et à venir, avec un focus sur la France.

1. Comprendre l’IA Act : une approche par les risques

L’IA Act classe les systèmes d’IA en quatre niveaux de risque, déterminant les obligations associées 179 :

Risque inacceptable : Interdits dans l’UE depuis février 2025. Exemples : Reconnaissance faciale en temps réel dans les espaces publics, notation sociale, exploitation de la vulnérabilité psychologique 3812. Risque élevé : Soumis à des exigences strictes (documentation technique, gestion des risques, conformité). Exemples : IA utilisée dans le recrutement, la santé, ou les infrastructures critiques 278. Risque limité : Obligation de transparence (ex. : informer les utilisateurs qu’ils interagissent avec une IA). Exemples : Chatbots, deepfakes 27. Risque minimal : Aucune obligation spécifique (ex. : filtres anti-spam) 1.

2. Obligations en vigueur en avril 2025

a) Interdictions déjà applicables

Depuis février 2025, les systèmes à risque inacceptable sont illégalement déployés en Europe. En France, cela inclut :

Les outils de surveillance biométrique généralisée 812. Les IA analysant les émotions ou la santé mentale des salariés 8. Les systèmes de notation sociale évaluant la « fiabilité » des individus 3.

b) Transparence pour les IA à risque limité

Les entreprises utilisant des chatbots RH ou des générateurs de contenu doivent informer clairement les utilisateurs de l’interaction avec une IA 78.

c) Préparation aux obligations à haut risque

Les systèmes à haut risque (ex. : outils de recrutement automatisés) devront être conformes d’ici août 2026. Cependant, dès avril 2025, les entreprises doivent :

Cartographier leurs systèmes d’IA et évaluer leur niveau de risque 39. Préparer la documentation technique et les processus de gestion des risques 210.

3. Échéances à anticiper

a) Août 2025 : Encadrement des modèles d’IA à usage général

Les modèles génératifs (ex. : ChatGPT) devront respecter des règles de transparence :

Divulguer les données d’entraînement utilisées. Documenter les risques de biais ou de cyberattaques 110. Respecter les droits d’auteur (ex. : éviter l’utilisation non autorisée de contenus protégés) 10.

b) Août 2026 : Conformité des systèmes à haut risque

Les obligations incluront :

Marquage CE pour les produits intégrant de l’IA (ex. : dispositifs médicaux). Audit externe par des organismes notifiés 29. Mise en place d’un système de surveillance post-commercialisation 7.

4. Les étapes clés pour se mettre en conformité

Cartographier les systèmes d’IA : Identifiez leur nature, leur risque et votre rôle (fournisseur, utilisateur, etc.) 3. Former les équipes : Les RH et les équipes techniques doivent comprendre les enjeux éthiques et juridiques 8. Documenter et auditer : Préparez les rapports techniques et les analyses d’impact (ex. : RGPD + IA Act) 210. Collaborer avec les autorités : En France, la CNIL reste compétente pour le RGPD et intervient sur les aspects liés aux données des systèmes d’IA 112.

5. Sanctions en cas de non-conformité

Les manquements peuvent entraîner des amendes allant jusqu’à 35 millions d’euros ou 7 % du chiffre d’affaires mondial, selon la gravité 78. La CNIL et les autorités de surveillance du marché (à désigner avant août 2025) superviseront l’application des règles 12.

Conclusion : L’IA éthique, un impératif stratégique

En avril 2025, les entreprises françaises doivent avoir initié leur transition vers une IA responsable. Entre interdictions immédiates et préparation aux échéances de 2026, l’enjeu est de concilier innovation et respect des droits fondamentaux. Pour anticiper, consultez les guides pratiques de la CNIL 1 ou du Cigref 3, et participez au Pacte sur l’IA de l’UE, incitant à une conformité anticipée

Comments are closed